Neste artigo serão analisadas as séries de retornos de seis principais índices de ações de setores da Bovespa. Foram escolhidos os quatro maiores índices setoriais pelo critério de valor de mercado ao final de março de 2018, índices Financeiro (IFNC), Consumo (ICON), Industrial (INDX) e Materiais (IMAT), além do índice de Governança (IGCX) e o próprio índice Bovespa (IBOV). Os retornos coletados foram entre as datas de 01/01/2009 a 31/12/2013 para o período considerado dentro da amostra, no qual são feitas algumas análises preliminares. O período fora da amostra, de onde são retirados os resultados de backtest se estende de 01/01/2014 a 08/05/2018. Em dias sem negociação nos mercados, os períodos iniciam-se na data útil seguinte e terminam em data útil imediatamente anterior.

No primeiro artigo desta sequência foi apresentada uma vasta revisão de literatura sobre a EVT e suas aplicações em finanças, com enfoque especial ao gerenciamento de risco. No segundo artigo a Teoria do Valor Extremo – EVT foi formalizada e apresentadas as equações para o cálculo tanto do VaR quanto do ES para um ativo financeiro. Também foi abordada a diferença entre medidas incondicionais e condicionais de risco. No presente artigo faremos uma aplicação da EVT para o cálculo do VaR condicional dos seis índices da Bovespa e faremos uma comparação deste modelo com o conhecido Riskmetrics.

A tabela 1 apresenta algumas das estatísticas descritivas mais importantes para as séries de retornos dos ativos no período completo, dentro e fora da amostra. É possível verificar que os retornos não podem ser considerados normais, com a estatística de Jarque-Bera rejeitando a hipótese nula e com o alto grau de curtose em excesso verificado para todos os índices analisados.

Também é possível verificar a grande autocorrelação serial entre os quadrados dos retornos, uma proxy para a autocorrelação das variâncias, através da estatística \(Q^2(10)\) de Ljung-Box, o que corrobora os fatos estilizados de séries financeiras, vide Cont (2001).

| Descritivas | IBOV | ICON | IFNC | IGCX | INDX | IMAT |

|---|---|---|---|---|---|---|

| Média | 0.00034 | 0.00069 | 0.00066 | 0.00052 | 0.00047 | 0.00043 |

| Máximo | 0.06929 | 0.05183 | 0.09295 | 0.06188 | 0.06388 | 0.07572 |

| Mínimo | -0.09211 | -0.07446 | -0.12288 | -0.08837 | -0.07370 | -0.09079 |

| Desvp | 0.01497 | 0.01148 | 0.01640 | 0.01269 | 0.01247 | 0.01820 |

| Assimetria | -0.03784 | -0.11441 | 0.00658 | -0.16642 | -0.01978 | 0.08989 |

| Curtose exc. | 2.13179 | 2.23608 | 3.23913 | 3.06149 | 2.43070 | 1.37705 |

| Jarque-Bera | 439.98*** | 488.47*** | 1013.68*** | 916.29*** | 571.28*** | 186.72*** |

| \(Q^2(10)\) | 122.14*** | 104.32*** | 97.44*** | 146.68*** | 256.11*** | 230.39*** |

| N.obs | 2311 | 2311 | 2311 | 2311 | 2311 | 2311 |

Na figura 1 são visualizadas as séries de retornos logarítmicos em estudo. Por inspeção visual simples é possível verificar a heterocedasticidade destes retornos, corroborando as estatísticas encontradas na tabela 1.

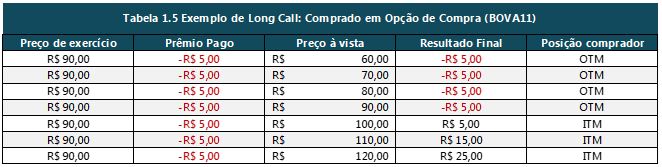

A figura 2 é mais interessante para se apreciar a normalidade destes retornos. Tratam-se de gráficos quantil-quantil feitos entre a amostra completa dos retornos e uma distribuição normal de referência. Para todas as séries é observado um desvio da normalidade nas caudas, configurando distribuições leptocúrticas em todos os casos.

Figura 1: Retornos dos índices do estudo. Período completo entre 02/01/2009 a 08/05/2018.

Figura 2: Análise de normalidade dos retornos através de gráficos quantil-quantil.

Filtro GARCH

Voltando-se para o período dentro da amostra, o filtro proposto GARCH(1,1) foi aplicado a estas séries e seus coeficientes estimados. A função do modelo GARCH neste primeiro estágio é a filtragem da série de perdas, de modo que os resíduos padronizados resultantes não sejam autocorrelacionados e tampouco possuam heterocedasticidade.

Para trabalhar com o VaR em seus quantis altos e portanto, modelar a cauda direita da distribuição, passa-se a trabalhar com a distribuição das perdas dos ativos. A tabela 2 apresenta novamente as estatísticas Jarque-Bera e Ljung-Box (Q e \(Q^2\)) desta vez para os resíduos padronizados resultantes da filtragem das perdas no primeiro estágio do modelo GARCH-POT. Enquanto que os resíduos padronizados, assim como os retornos, não são normais como já se esperava, as estatísticas de autocorrelação agora estão todas em favor da ausência desta. Para todos os índices analisados, não é possível rejeitar \(H_0\) nos testes de autocorrelação, tanto para os resíduos (\(Q(10)\)) como para os seus quadrados (\(Q^2(10)\)) em evidente contraste com os valores apresentados na tabela 1 quando foram analisados os retornos destes índices. Evidência que a filtragem inicial foi bem sucedida em remover autocorrelação serial tanto nas perdas quanto na variância destas.

| Estatística | IBOV | ICON | IFNC | IGCX | INDX | IMAT |

|---|---|---|---|---|---|---|

| Curtose exc. | 1.04702 | 0.80399 | 1.07619 | 1.06174 | 0.94823 | 0.85436 |

| Jarque-Bera | 59.68837 | 35.65255 | 60.39086 | 65.08960 | 49.34559 | 38.82424 |

| (0.00000) | (0.00000) | (0.00000) | (0.00000) | (0.00000) | (0.00000) | |

| Q(10) | 2.22678 | 4.56100 | 2.93792 | 2.56408 | 2.64320 | 2.44096 |

| (0.91608) | (0.57468) | (0.82868) | (0.87790) | (0.86803) | (0.89259) | |

| \(Q^2(10)\) | 8.48918 | 3.04788 | 3.72839 | 6.32895 | 5.37480 | 5.52198 |

| (0.13786) | (0.81307) | (0.70876) | (0.32562) | (0.45069) | (0.42978) |

Sendo assim, com retornos padronizados que não são normalmente distribuídos e possuem cauda longas com excesso de curtose, mas que após filtragem não apresentam mais autocorrelação ou heterocedasticidade, pode-se passar ao segundo estágio do modelo, ou seja, aplicar a teoria do valor extremo através do método peaks over treshold para parametrizar a cauda direita das distribuições de perdas dos ativos.

Método POT

Os resíduos padronizados são tratados como as realizações do processo de inovação no modelo GARCH. Estas inovações serão analisadas sob a ótica da EVT para a obtenção dos parâmetros da GPD que definem a cauda direita de sua distribuição.

Para tanto, deve ser estabelecido um limiar u adequado para cada uma das séries, de modo que seja satisfeito o teorema de Pickands-Balkema-de Haan. Este valor de limiar será diferente para cada série e sua escolha deve seguir os princípios delineados no artigo Medidas de Risco com a Teoria do Valor Extremo através da função média dos excessos. Entretanto, considerando o trade-off existente entre o viés e a variância dos parâmetros da GPD estimados com relação a escolha do valor deste limiar, pode-se abordar o problema desta escolha de outra forma.

Neste artigo foi utilizado o quantil empírico a 90% para a escolha do valor do limiar. Conforme visto anteriormente, um valor de limiar que resulte em um número de excessos observados (\(N_u\)) entre 100 e 130 é o mais indicado. Considerando o tamanho da janela de dados dentro da amostra para os índices sob análise, este quantil resulta em número de excessos nesta quantidade.

A escolha do limiar através de um quantil empírico fixo também é mais adequada considerando-se que para a fase de backtest do modelo é necessário reavaliar o valor deste limiar para cada dia dentro do período fora da amostra, o que se tornaria inviável de ser feito através da análise gráfica da função média dos excessos.

Escolhido o limiar u, trata-se de obter a série de inovações em excesso ao limiar \(Z^u_t:\{Z^u_t = Z_t-u |Z_t > u\}\), onde \(Z_t\) são as inovações, em que os resíduos padronizados encontrados são suas realizações e \(Z^u_t\) são portanto, as inovações em excesso.

A esta série de inovações em excesso é aplicada a função log-verossimilhança dada na equação (1) que por sua vez é maximizada em relação aos parâmetros \(\xi\) e \(\psi\) para a obtenção de suas estimativas.

\[\begin{align}

\ln L(\xi, \psi; Z^u_j)=&\sum\limits_{j=1}^{N_u}\ln g_{\xi, \psi}(Z^u_j)\nonumber\\

=&-N_u \ln \psi-\left(1+\frac{1}{\xi}\right)\sum\limits_{j=1}^{N_u}\ln \left(1+\xi\frac{Z^u_j}{\psi}\right)

\tag{1}

\end{align}\]

A tabela 3 apresenta os valores destes parâmetros e seus erros padrão para cada um dos índices, com a estimação feita com os dados do período dentro da amostra. Também são apresentados o número de observações dentro da amostra para o total dos resíduos padronizados, assim como o número de excessos observados (\(N_u\)) para o limiar escolhido (\(u\)). Observa-se como o número de excessos varia de acordo com o índice (asim como o total de observações), porém todos ficam em torno de 120 excessos, que é considerado um valor ideal.

| IBOV | ICON | IFNC | IGCX | INDX | IMAT | |

|---|---|---|---|---|---|---|

| N.obs. | 1236 | 1236 | 1236 | 1236 | 1236 | 1236 |

| Limiar \(u\) | 1.27441 | 1.21387 | 1.24376 | 1.28281 | 1.27872 | 1.24701 |

| Num.exc. \(N_u\) | 124 | 124 | 124 | 124 | 124 | 124 |

| Par. forma \(\xi\) | -0.00769 | -0.06855 | -0.08808 | 0.02810 | 0.06821 | -0.01423 |

| Erro padrão | 0.08675 | 0.09660 | 0.06545 | 0.10628 | 0.10726 | 0.09281 |

| Par. escala \(\psi\) | 0.57865 | 0.65301 | 0.64641 | 0.56854 | 0.51291 | 0.54368 |

| Erro padrão | 0.07225 | 0.08603 | 0.07164 | 0.07910 | 0.07168 | 0.07021 |

| Quantil \(z_{0.975}\) | 2.07417 | 2.07937 | 2.08917 | 2.08844 | 2.02629 | 1.99505 |

| Quantil \(z_{0.990}\) | 2.59690 | 2.60662 | 2.59265 | 2.63717 | 2.55947 | 2.48030 |

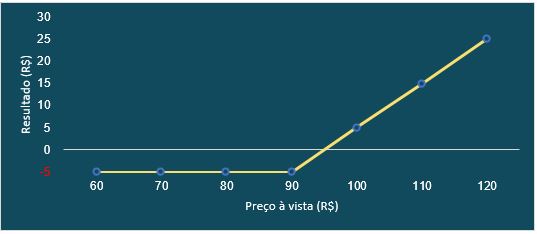

Na figura 3 é possível visualizar os gráficos de ajuste das inovações em excesso de cada um dos índices contra suas distribuições GPD de referência, ou seja, aquelas com os parâmetros de forma e escala estimados para os respectivos índices. Verifica-se que a distribuição destes excessos pouco se desvia com relação a curva de referência, denotando um bom ajuste dos dados ao modelo teórico. Em contraste, quando modelados diretamente através de uma distribuição normal, as séries de retornos se afastavam consideravelmente de suas referências como já apresentado na figura 2. Ao se utilizar um método semi-paramétrico como o proposto, modelando apenas uma parte da cauda da distribuição, a parte que interessa para a modelagem de risco, obtém-se uma estimação muito mais próxima da realidade que os dados apresentam.

Figura 3: Qualidade do ajuste dos dados de inovações em excesso contra uma GPD de referência. Período dentro da amostra.

Avaliação dos modelos

A avaliação dos modelos aqui referidos concentra-se em testar através de backtest o modelo EVT condicional apresentado, o qual utiliza a metodologia em dois estágios proposta por McNeil and Frey (2000) assim como o modelo proposto por RiskMetrics (1995), sendo, portanto, dois modelos testados e comparados para fins de estimação da medida de risco.

O modelo EVT incondicional aqui proposto é diferente daquele encontrado nas outras referências. A filtragem através de um modelo GARCH é realizada e os resíduos padrão resultantes são utilizados para estimar o quantil desejado através da EVT, entretanto, ao se calcular a medida de risco são utilizados a média e o desvio padrão incondicionais do filtro, resultando em menor volatilidade do VaR. Uma vantagem teórica deste método é que se está aplicando a teoria de valor extremo a uma série iid, os resíduos padronizados, conforme preconizado pela teoria. Outra vantagem de cunho mais prático é que esta abordagem se torna um modelo que não possui a alta volatilidade dos modelos condicionais e apresenta de forma mais branda que os modelos incondicionais (às vezes chamados de estáticos) os agrupamentos nas violações ao VaR.

Para fazer o backtest, considere a série \(x_1, x_2, \ldots, x_m\), com \(m\gg n\) e o conjunto de dias \(T = \{n, \ldots, m-1\}\). Uma janela de dados de tamanho fixo contendo as últimas \(n\) observações é utilizada e para cada dia \(t \in T\) é reestimado o valor de \(VaR^t_\alpha\). O período de teste fora da amostra vai de 01/01/2015 a 08/05/2018, com dados diários para as perdas dos índices sob análise. O número de observações (\(n\)) dentro da janela de dados utilizada para fazer a estimação dos modelos para cada um dos índices é aquele apresentado na tabela 3 (N.obs.), esse valor é fixo para cada série. Portanto, a partir do início do período de teste, esta janela de tamanho fixo avança um dia e o modelo é reestimado, resultando no valor estimado de \(VaR_\alpha^t\), ou seja, a medida de risco calculada ao final do dia \(t\) que deverá ser comparada a perda incorrida no dia a frente, \(t+1\).

O quantil para a definição do limiar u é fixo em 0,90, o que resultará em valores distintos de limiar para cada rodada do teste, e possivelmente um número diferente de excessos observados. Entretanto essas diferenças, considerando o tamanho fixo da janela de dados, será muito pequeno em torno de uma unidade apenas. Mantém-se assim, um número de excessos em torno de 120 observações, valor adequado para se fazer as estimativas dos parâmetros da GPD.

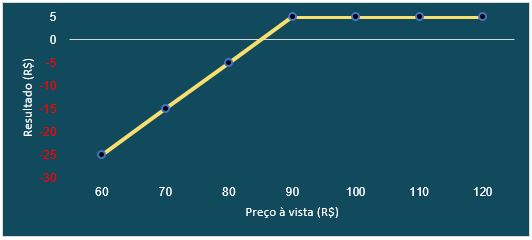

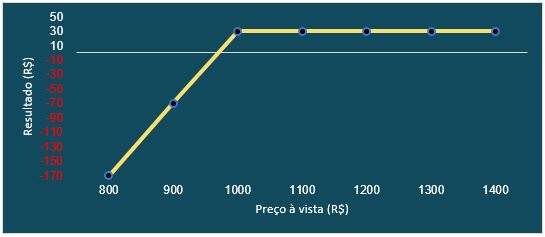

A figura 4 apresenta o resultado do backtest para o modelo EVT condicional para cada um dos índices analisados. É possível verificar como a medida condicional de risco oscila de valor, acompanhando a volatilidade do índice, sendo especialmente responsiva a grandes choques. Em comparação com o modelo Riskmetrics, o EVT apresenta maior persistência em seu nível medido de risco após um choque de volatilidade, ou em outras palavras, uma menor taxa de decaimento. Através da figura 5 pode-se verificar esta condição para o índice IBovespa onde, após a grande perda ocorrida em 18 de maio de 2017, fica evidente que o modelo retorna aos seus níveis de risco anteriores de forma mais lenta que a medida Riskmetrics. Entende-se por modelos incondicionais aqueles em que a volatilidade histórica de toda a janela de dados é utilizada para calcular as medias de risco. É nítido como o modelo condicional, que utiliza a previsão para a média e volatilidade das perdas e então utiliza-os para obter a medida de risco, é muito mais responsivo a alterações no regime de volatilidade do ativo. Um modelo incondicional, por sua vez, não responde de forma acentuada a variações de curto-prazo na volatilidade do ativo, pois estas observações mais extremas são atenuadas em meio a todas as outras observações utilizadas da janela de dados.

Figura 4: \(VaR_{99\%}\) no modelo EVT condicional para todos os índices. Violações demarcadas.

Figura 5: Teste fora da amostra para o IBOV. O modelo EVT condicional (linha sólida) possui menor taxa de decaimento após um choque de volatilidde que o modelo Riskmetrics (linha tracejada).

Uma violação é dita ocorrida quando a perda observada é maior que a medida de risco estimada no dia anterior, \(x_{t+1}>VaR^t_\alpha\) para um \(\alpha\) dentro do conjunto de níveis de significância, neste artigo \(\alpha \in \{0,975; 0,990\}\). A tabela 4 apresenta em termos percentuais as violações ocorridas para cada um dos modelos para os níveis de cobertura dados. Dentre os dois modelos analisados, o EVT condicional se saiu melhor nos dois níveis de cobertura. %Os modelos condicionais apresentaram uma tendência a subestimação do risco, com um número superior de violações ao esperado. Os modelos incondicionais, ao contrário, superestimam o risco e apresentam tendência a um número menor de violações. Dentre os modelos estimados o EVT condicional apresentou as violações percentuais mais próximas ao valor esperado, \(1-\alpha\).

| Modelo | IBOV | ICON | IFNC | IGCX | INDX | IMAT |

|---|---|---|---|---|---|---|

| Cobertura = 1% | ||||||

| EVT Condicional | 0.65 | 1.21 | 0.74 | 1.12 | 0.93 | 0.93 |

| RiskMetrics | 1.02 | 1.68 | 1.12 | 1.30 | 1.40 | 1.40 |

| Cobertura = 2.5% | ||||||

| EVT Condicional | 2.14 | 2.61 | 2.14 | 2.14 | 2.42 | 2.70 |

| RiskMetrics | 2.42 | 2.79 | 2.14 | 2.61 | 3.54 | 2.61 |

Testes estatísticos

Pode ser realizado um teste estatístico para verificar se o modelo para \(VaR_\alpha\) foi corretamente especificado levando-se em consideração o seu nível de cobertura, \(1-\alpha\). Este teste foi originalmente proposto por Kupiec (1995) e pretende derivar propriedades estatísticas formais do teste utilizado para verificar a precisão de modelos VaR. Este teste permite inferir se a frequência de violações ao VaR é consistente com o valor esperado destas, o nível de cobertura. Sob a hipótese nula de um modelo corretamente especificado o número de violações segue uma distribuição binomial e o teste toma a forma de razão de verossimilhança com a seguinte estatística:

\[\begin{equation}

LR_{uc}=-2\ln\left(\frac{(1-p)^{N-X}p^X}{(1-\frac{X}{N})^{N-X}(\frac{X}{N})^X}\right)

\tag{2}

\end{equation}\]

onde \(p\) é o nível de cobertura, \(N\) é o número de observações do período fora da amostra e \(X\) neste caso é o número de violações ocorridas.

Este teste não faz nenhum tipo de assunção, e por conseguinte não testa, a hipótese de independência entre as violações, sendo considerado um teste de cobertura incondicional para o VaR.

Um teste condicional é aquele proposto, entre outros, por Christoffersen and Pelletier (2004). A hipótese de independência entre as violações está relacionada a duração entre as observações destas. O tempo que se passa entre uma violação e outra deve ser independente e não formar agrupamentos (clusters). Sob a hipótese nula de um modelo corretamente especificado, a duração não deve possuir memória. Como a única distribuição contínua que não possui memória é a distribuição exponencial, os autores propuseram ajustar os dados a uma distribuição Weibull da qual a exponencial é um caso particular quando o parâmetro \(b=1\) e, portanto, o teste é feito sobre este parâmetro. O teste de duração de Christoffersen é feito sob a forma de razão de verossimilhança, sendo a função densidade de uma Weibull:

\[\begin{equation}

f_W(D; a, b) = \begin{cases}

a^b b D^{b-1}e^{-(aD)^b}, &D \geq 0\\

0,&D<0.

\end{cases}

\tag{3}

\end{equation}\]

onde \(D\) é a duração entre as violações e \(a\) e \(b\) são os parâmetros da distribuição.

Nota-se que este teste é destinado apenas a verificação da hipótese de independência das violações. Em conjunto com o teste de Kupiec, a tabela 5 fornece um panorama completo sobre a adequação das especificações de modelos VaR.

| Modelo | Estatística | IBOV | ICON | IFNC | IGCX | INDX | IMAT |

|---|---|---|---|---|---|---|---|

| Cobertura 1% | |||||||

| cevt | LRuc | 1.50 | 0.45 | 0.77 | 0.14 | 0.05 | 0.05 |

| cevt | LRdur | 3.73 | 1.45 | 0.53 | 0.00 | 2.36 | 0.03 |

| riskmetrics | LRuc | 0.01 | 4.12** | 0.14 | 0.91 | 1.52 | 1.52 |

| riskmetrics | LRdur | 0.05 | 0.13 | 0.09 | 0.01 | 3.88** | 0.22 |

| Cobertura 2.5% | |||||||

| cevt | LRuc | 0.59 | 0.05 | 0.59 | 0.59 | 0.03 | 0.17 |

| cevt | LRdur | 0.30 | 0.02 | 0.94 | 0.37 | 0.83 | 0.99 |

| riskmetrics | LRuc | 0.03 | 0.37 | 0.59 | 0.05 | 4.22** | 0.05 |

| riskmetrics | LRdur | 0.96 | 0.25 | 0.00 | 0.69 | 0.02 | 0.53 |

Inspecionando a tabela 5 verifica-se como o modelo EVT condicional, especialmente para o nível de cobertura a 1% é superior ao seu rival, prevalecendo como o único modelo a não rejeitar a hipótese nula a 95% de confiança para ambos os testes e níveis de cobertura.

Conclusão

Este artigo tratou de estimar e comparar dois modelos de VaR para seis índices de ações em segmentos diferentes da Bovespa. Os modelos EVT condicional e Riskmetrics foram estudados e comparados com base em dois tipos diferentes de testes. Especial ênfase foi dada ao modelo EVT condicional o qual se utiliza da teoria do valor extremo para chegar ao resultado da medida de risco. Dentre os modelos estimados, o EVT condicional apresentou os percentuais de violações mais próximos ao valor esperado.

Nos testes estatísticos de cobertura incondicional e independência, a superioridade do modelo EVT condicional se apresenta de forma mais concreta. Este modelo não apresentou rejeição a hipótese nula da correta especificação, tanto para o teste de Kupiec quanto para o teste de duração de Christoffersen e Pelletier ao nível de confiança de 95%.

Apesar de os modelos condicionais se mostrarem mais adequados a estimação do VaR através dos testes estatísticos apresentados, este tipo de modelo, em virtude de sua grande variabilidade ao longo do tempo no valor estimado da medida de risco, impõe uma barreira de cunho prático a sua implementação. Para alterar o VaR tão drasticamente e em curto período de tempo, a instituição financeira deve ser capaz de rapidamente alterar a alocação de ativos de seu portfólio, o que não é a realidade da grande maioria destas instituições. O mercado pode não possuir a liquidez ou a profundidade necessária para realizar estas operações, isso sem contar os custos envolvidos nas transações.

Além deste trade-off entre superioridade teórica do modelo EVT condicional e sua implementação prática mais complexa, a medida de risco VaR atualmente está sendo utilizada em conjunto com a Expected Shortfall. Esta última pode ser derivada a partir do modelo EVT condicional com facilidade e deve ser abordada em outro trabalho, juntamente com testes específicos para o ES com intuito de averiguação do melhor modelo.

Christoffersen, Peter, and Denis Pelletier. 2004. “Backtesting Value-at-Risk: A Duration-Based Approach.” Journal of Financial Econometrics 2 (1). Oxford University Press: 84–108.

Cont, R. 2001. “Empirical properties of asset returns: stylized facts and statistical issues.” Quantitative Finance 1 (2): 223–36. doi:10.1080/713665670.

Kupiec, Paul H. 1995. “Techniques for Verifying the Accuracy of Risk Measurement Models.” The Journal of Derivatives 3 (2). Institutional Investor Journals: 73–84.

McNeil, Alexander J, and Rüdiger Frey. 2000. “Estimation of tail-related risk measures for heteroscedastic financial time series: an extreme value approach.” Journal of Empirical Finance 7 (3-4): 271–300. doi:10.1016/s0927-5398(00)00012-8.

RiskMetrics. 1995. “Technical Document – 3rd Edition.” J.P Morgan Guaranty Trust Company.